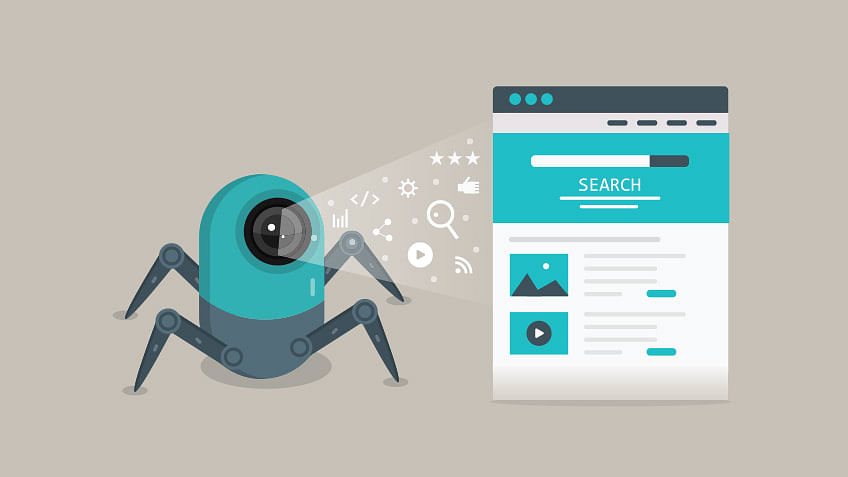

Web crawler adalah teknologi penting yang bekerja di balik layar internet modern. Tanpa adanya bot ini, mustahil mesin pencari seperti Google bisa menyajikan jutaan hasil hanya dalam hitungan detik. Faktanya, jumlah website di dunia terus bertambah hingga ratusan juta, dan jelas tidak mungkin manusia bisa mengecek satu per satu secara manual.

Masalahnya, tanpa web crawler, informasi di internet akan berantakan, sulit diakses, dan tidak bisa dimanfaatkan secara maksimal. Teknologi inilah yang memastikan setiap halaman website bisa ditemukan, dibaca, lalu diorganisasi agar tampil rapi di hasil pencarian. Artikel ini akan membahas apa itu web crawler, fungsi pentingnya dalam dunia digital, hingga cara kerjanya yang membuat internet jadi lebih mudah digunakan semua orang..

Apa itu Web Crawler?

Web crawler adalah program atau bot otomatis yang dirancang untuk menelusuri, membaca, dan mengumpulkan data dari halaman-halaman website. Kamu bisa membayangkannya seperti “robot penjelajah” yang berjalan dari satu link ke link lain, lalu menyimpan informasi yang ditemuinya ke dalam database search engine.

Mesin pencari besar seperti Google, Bing, atau Yahoo punya web crawler masing-masing. Misalnya, Google menggunakan Googlebot untuk merayapi situs di seluruh dunia. Bot ini memastikan konten baru atau update di sebuah website bisa segera masuk ke hasil pencarian.

Web crawler berbeda dengan indexing. Crawling adalah proses mengunjungi dan membaca halaman, sementara indexing adalah proses menyimpan dan mengorganisasi data yang sudah di-crawl. Selain itu, crawling juga berbeda dengan web scraping. Kalau scraping biasanya untuk kepentingan spesifik seperti analisis data, crawling lebih fokus pada pengumpulan data masif untuk pencarian.

Fungsi Web Crawler

Kehadiran web crawler bukan hanya sekadar untuk “jalan-jalan” di internet, tapi punya fungsi vital yang menentukan bagaimana informasi tersaji kepada pengguna. Berikut beberapa fungsi utamanya:

1. Mengumpulkan Informasi untuk Mesin Pencari

Fungsi paling utama web crawler adalah mengumpulkan data dari berbagai halaman web. Setiap kali bot ini merayapi sebuah situs, ia membaca teks, gambar, hingga struktur halaman. Informasi tersebut kemudian dikirim ke server mesin pencari untuk diproses lebih lanjut. Hasilnya, ketika kamu mencari sesuatu di Google, data yang ditampilkan berasal dari kumpulan informasi yang sudah diambil oleh crawler sebelumnya.

2. Membantu Proses Indexing

Crawling dan indexing adalah dua hal yang saling terhubung. Setelah crawler mengunjungi sebuah halaman, informasi tersebut diorganisasi dan dimasukkan ke dalam indeks mesin pencari. Tanpa crawling, indexing tidak akan berjalan. Jadi, web crawler bisa dibilang sebagai pintu masuk utama agar sebuah website bisa “terlihat” di mesin pencari.

3. Memastikan Update Konten Terdeteksi

Internet selalu berubah. Ada konten baru setiap detik, sementara halaman lama sering diperbarui. Web crawler memastikan perubahan ini tidak terlewat. Jika kamu memperbarui artikel di website, crawler akan kembali berkunjung untuk membaca update tersebut lalu memperbaruinya di database mesin pencari. Dengan begitu, hasil pencarian yang ditampilkan selalu relevan.

4. Menentukan Ranking di Mesin Pencari

Meski algoritma ranking ditentukan oleh banyak faktor, crawler berperan besar dalam mengumpulkan sinyal-sinyal SEO. Bot ini mengecek internal link, kualitas konten, struktur website, mobile friendly website, hingga kecepatan loading. Semua informasi ini digunakan mesin pencari untuk menilai apakah halamanmu layak tampil di peringkat atas atau tidak.

5. Digunakan di Luar Mesin Pencari

Web crawler adalah bot yang tidak hanya bekerja untuk Google atau Bing. Banyak marketplace menggunakan crawler untuk memantau harga kompetitor. Peneliti juga memanfaatkannya untuk mengumpulkan data dalam skala besar, sementara digital marketer sering memakai crawler untuk analisis keyword, backlink, hingga performa website.

6. Mengoptimalkan Efisiensi Pencarian

Bayangkan kalau tidak ada crawler, setiap kali pengguna melakukan pencarian, mesin pencari harus menjelajahi internet secara real-time dari awal. Itu jelas tidak mungkin. Dengan adanya crawler, semua data sudah siap di indeks sehingga pencarian bisa dilakukan secepat mungkin.

Cara Kerja Web Crawler

Web crawler adalah teknologi otomatis yang punya sistem kerja terstruktur. Meski terlihat sederhana, sebenarnya prosesnya melibatkan beberapa tahapan penting. Berikut langkah-langkah cara kerja web crawler yang perlu kamu tahu:

1. Memulai dari URL Seed

Proses crawling selalu dimulai dari daftar URL (Uniform Resource Locator) awal, yang disebut seed URL. URL ini bisa berasal dari database mesin pencari, sitemap yang dikirim webmaster, atau link populer di internet. Dari sinilah crawler mulai merayap untuk menemukan konten baru.

2. Merayapi Link (Crawling)

Setelah mengunjungi URL seed, crawler akan membaca semua link yang ada di dalam halaman tersebut. Setiap link baru ditambahkan ke daftar antrian untuk dikunjungi berikutnya. Dengan cara ini, bot bisa menjelajahi jutaan bahkan miliaran halaman hanya dari satu titik awal.

3. Membaca dan Menyimpan Konten

Cara kerja web crawler berikutnya adalah membaca dan menyimpan konten. Saat mengunjungi halaman, crawler membaca kontennya: teks, gambar, meta tag, struktur HTML, hingga internal dan eksternal link. Semua data ini kemudian dikirim ke server mesin pencari untuk dianalisis. Konten yang relevan dan sesuai aturan akan diproses lebih lanjut.

4. Indexing ke Database

Setelah data dikumpulkan, mesin pencari melakukan indexing. Proses ini mengorganisasi konten agar bisa dipanggil dengan cepat saat pengguna melakukan pencarian. Indexing inilah yang memungkinkan Google menampilkan jutaan hasil dalam hitungan detik. Tanpa crawler, database mesin pencari akan kosong.

5. Prioritas & Aturan Crawling

Tidak semua halaman di internet akan dikunjungi dengan frekuensi sama. Mesin pencari menggunakan sistem prioritas yang disebut crawl budget. Halaman populer, sering diupdate, atau dianggap penting akan lebih sering di-crawl. Selain itu, crawler juga menghormati aturan dari file robots.txt, yang bisa membatasi atau melarang bot mengakses bagian tertentu dari sebuah website.

6. Refresh dan Update Data

Internet terus berubah. Konten lama bisa diperbarui, atau bahkan dihapus. Web crawler adalah bot yang bekerja secara berulang dengan kembali mengunjungi halaman lama untuk mengecek apakah ada perubahan. Dengan cara ini, indeks mesin pencari tetap fresh dan relevan dengan kondisi terbaru.

7. Efisiensi dan Skalabilitas

Mesin pencari besar seperti Google menjalankan ribuan crawler secara paralel di seluruh dunia. Hal ini dilakukan agar proses crawling tetap cepat, efisien, dan mampu mengimbangi pertumbuhan internet yang masif.

Cara Optimasi Web Crawling bagi Website

Ingat, web crawler adalah pintu masuk utama agar mesin pencari bisa membaca dan mengindeks kontenmu. Kalau crawler kesulitan menjelajahi situs, otomatis ranking di hasil pencarian juga bisa terpengaruh. Maka dari itu, penting untuk memahami bagaimana cara mengoptimalkan website agar lebih ramah terhadap proses crawling. Berikut beberapa langkah optimasi yang bisa kamu terapkan:

1. Gunakan Struktur URL yang Rapi

Struktur URL yang jelas dan konsisten memudahkan crawler memahami hierarki halaman. Hindari penggunaan parameter berlebihan atau URL yang terlalu panjang. Sebagai contoh, domain.com/blog/seo-tips jauh lebih ramah crawler daripada domain.com/?p=123&ref=abc.

2. Manfaatkan XML Sitemap

XML sitemap berfungsi sebagai peta yang menunjukkan halaman penting di website kamu. Dengan menyediakan sitemap, kamu membantu crawler menemukan konten utama lebih cepat, bahkan jika halaman tersebut tidak memiliki banyak link internal. Pastikan sitemap selalu diperbarui setiap kali ada halaman baru.

3. Optimalkan Internal Linking

Link internal adalah jalur yang digunakan web crawler untuk menavigasi situsmu. Semakin baik internal linking, semakin mudah bot menemukan halaman penting. Hindari halaman “orphan” (halaman tanpa link masuk), karena kemungkinan akan terlewat oleh crawler.

4. Perhatikan Robots.txt

File robots.txt berfungsi memberi instruksi kepada crawler bagian mana dari situsmu yang boleh atau tidak boleh diakses. Atur file ini dengan hati-hati. Jangan sampai secara tidak sengaja kamu memblokir halaman penting yang justru ingin diindeks Google.

5. Tingkatkan Kecepatan Website

Crawler punya keterbatasan waktu ketika mengunjungi website. Jika loading terlalu lama, bot bisa berhenti sebelum menjelajahi semua halaman. Gunakan teknik optimasi kecepatan seperti kompresi gambar, caching, atau memanfaatkan CDN agar situsmu lebih cepat.

6. Pastikan Website Mobile-Friendly

Google adalah mesin pencari yang mengutamakan mobile-first indexing, artinya web crawler akan menilai performa website berdasarkan versi mobile. Pastikan tampilan situs responsif dan tidak ada elemen yang menghalangi crawler membaca konten versi mobile.

7. Atasi Duplicate Content

Konten duplikat bisa membingungkan crawler dan mengurangi efisiensi crawl budget. Gunakan tag canonical untuk menandai halaman utama, atau hindari membuat halaman dengan konten mirip secara berlebihan.

8. Perbarui Konten Secara Berkala

Konten yang rutin diperbarui lebih sering dikunjungi crawler. Mesin pencari juga cenderung memberi prioritas pada halaman dengan update terbaru. Dengan strategi konten yang konsisten, kamu bisa memastikan crawler tidak melewatkan situsmu.

9. Pantau dengan Google Search Console

Alat ini memungkinkan kamu melihat bagaimana Googlebot merayapi situsmu. Kamu bisa memeriksa error, halaman yang tidak terindeks, hingga masalah robots.txt. Dengan memantau data ini, optimasi crawling bisa dilakukan lebih tepat sasaran.

Sudah Paham Apa itu Web Crawler?

Dari pembahasan tadi, jelas bahwa web crawler adalah teknologi vital yang membuat internet tetap terstruktur dan mudah diakses. Tanpa crawler, mesin pencari tidak akan mampu menampilkan informasi yang relevan sesuai kebutuhan pengguna. Bagi pemilik website, memahami cara kerja dan optimasi crawling sangat penting agar situs lebih cepat terindeks dan berpeluang tampil di halaman pertama Google.

Selain optimasi teknis, pondasi penting dari website adalah nama domain. Domain yang tepat bukan hanya mempermudah crawler mengenali situs, tapi juga meningkatkan kredibilitas bisnis digital kamu. Jika kamu berencana memulai atau mengembangkan website, pastikan untuk beli domain di RNA. Dengan layanan terpercaya dan harga terjangkau, RNA membantu kamu membangun fondasi digital yang kuat sejak awal.